生成AI活用パターンとして、漫画などの背景素材を考えてみます。

現実に存在する風景写真などをもとに作成する場合、従来は、

・看板のロゴや社名など、商標登録されているものは除外する

・背景が目立ちすぎないよう、特徴的すぎる部分は簡略化する

・現実の風景そのままではなく、作風に合うように線画を抽出する

など、作画工程で考えることがいくつもありました。

そのすべてを生成AIで今すぐ解決することは難しそうですが、生成AIで簡易的に背景を作成することはできそうです。

画像編集ソフトで背景作成

写真などをもとにして背景素材を作成する方法自体は、CGの技術として以前から存在します。

生成AI(ここではStable Diffusion)で作成した背景と比較するため、まずは画像編集ソフトを用いて背景を作成してみます。

なお、画像編集ソフトはクリップスタジオを利用しています。

今回はこちらの写真を加工します。校舎ですね。

(写真ACよりお借りしました)

まずは色調補正→彩度を調整してグレースケールにします。

まだ写真らしさが強いです。

続いて、レベル補正でコントラストを調整します。

真っ白にする部分、真っ黒にする部分、中間色の3つのバランスを調整すると、幾分背景らしさが出てきました。

続いて、線画抽出と、グレーの濃さごとに3段階ほどで単色化します。

単色化は、レイヤーを複製して二値化の閾値を調整することで表現しています。

かなり背景らしくなってきました。

仕上げに、単色化したレイヤーをトーン化します。

これで背景素材の完成です。

背景らしい印象にはなったものの、手書きの背景と比べると、書き込み量が画一的であったり、無駄に情報量が多くなっています。

冒頭で挙げたような、作画工程で考える部分の対応ができていないためです。

画像編集ソフトですぐに作れるこの方法では、画風にもよりますが背景としての違和感が大きいかもしれません。

ちなみに、レベル補正や線画抽出、二値化などの詳しい解説は、使用するソフトによって異なりますし、表現したい画風によってもかなり設定が変わってくるのでここでは触れません。

生成AIで背景作成

それでは、Stable Diffusionを利用した場合はどうなるでしょうか。

こちらも先ほどと同じ写真をもとにします。

プロンプト:

(best quality, masterpiece:1.3), line art, screen tone, monochrome, grayscale, cartoon, comic background, (high contrast, black and white:1.3),

scenery, school buildingネガティブプロンプト:

(worst quality, low quality:1.4), EasyNegative, lowresプロンプトはかなりシンプルです。

書き込み量や情報量を減らすため、モデルデータは実写系ではなくアニメ系のものを利用します。

これに加えて、コントロールネットで写真を読み込み、Preprocessorはlineartを指定しました。

生成された画像がこちらです。

この段階でグレースケールにしつつ、写真と比べると全体的に情報量が削減されています。

生成された画像を画像編集ソフトで仕上げていきます。

手順は先ほどと同様に、まずレベル補正でコントラストを高くします。

この時点でかなり背景らしさがあります。

従来の方法では、情報量を削減するためにここから単色化(3段階くらいで二値化)をしていましたが、生成AIを利用した場合はすでに情報量が少なくなっているので、その工程を飛ばして線画抽出+トーン化のみ行います。

これで完成です。

従来の方法と比べて、かなり背景らしくなったのではないでしょうか。

青空の部分は切り抜いて、別途青空トーンを貼るとより背景らしくなりそうです。

生成AIで背景作成その2

生成AIで、1パターン別の背景を作ってみます。

こちらも元の写真は写真ACからお借りしました。

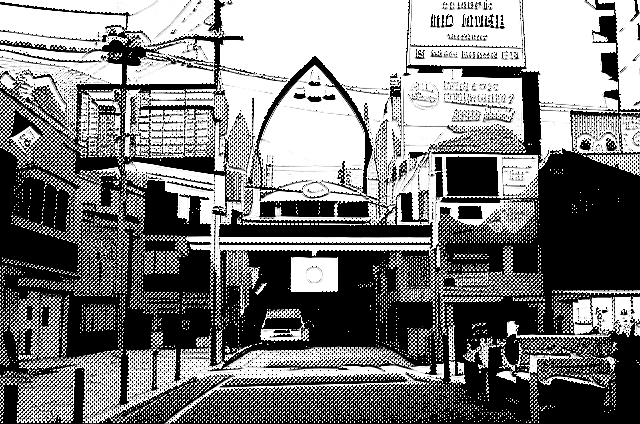

商店街の風景です。

看板や文字情報が多く、従来の方法ではそのまま使うことができません。

こちらをStable Diffusionに読み込んで生成してみます。

設定は先ほどと同様です。(プロンプトの school building の箇所のみ shopping district に変更しています)

特別な設定もなく、看板や文字情報がほとんどなくなりました。

右上あたりにある文字のような部分も、元の写真にあるような、商標に触れる要素ではなくなりました。

続いて画像編集ソフトに移動して、レベル補正でコントラストを高めます。

全体的なシルエットは残しながらも、情報量はかなり削減されています。

仕上げに、線画抽出+トーン化をします。

漫画の背景素材として使えそうな状態になりました。

生成AIでより簡単に背景素材を作るには

今回検証した背景素材作成方法は、画像編集ソフトでの作業が手作業であったり、多少人の手が必要になります。

生成AIをさらに活用することで、作業工程をより早くより簡単にする方法があります。

漫画背景作成用LoRAを作成することで、作業工程をさらにスムーズにできそうです。

残念ながら現時点では漫画背景作成用LoRAは見つけられませんでしたが、たとえば、

・ラインアートやモノクロ系のLoRAを利用する

・自身の過去作の漫画背景を学習させる

・商用利用可能・AI学習可能な漫画背景素材を学習させる

などの方法で、自分専用の漫画背景作成用LoRAを作ることができます。

学習精度にもよりますが、もしかしたら今回検証した工程のうち、画像編集ソフトでの作業が不要に、つまり写真などの元データからすぐに漫画背景が作成できるようになるかもしれません。

特に過去作が多い作家さんであれば、自身の過去作を学習させることで、これまでと画風や雰囲気を変えることなく新しい漫画背景素材を生成できるようになるので、作画コスト削減にとても有効かと思います。

ちなみにラインアートやモノクロ系のLoRAは過去記事「【Stable Diffusion】LORAなどの追加学習データ集(ラインアート・モノクロ編part1)」「【Stable Diffusion】LORAなどの追加学習データ集(ラインアート・モノクロ編part2)」でまとめています。

(漫画背景作成は試していないので作業工程がスムーズになるかはわかりません)

まとめ

試しにキャラクター部分もStable Diffusion+クリップスタジオで追加してみました。

背景の違和感はほとんどなさそうです。

生成AIのネックでもある文字の生成精度、Stable Diffusion 3でもまだ日本語には対応しきれていないようですが、その副産物として「認識できない架空の文字や看板」が簡単に生成できるのも面白いところです。

今回は生成AIにはStable Diffusionを使用しましたが、生成AIはコントロールネットと同等の機能が使えれば何でも問題ないです。

画像編集ソフトは、トーン化のしやすさを考えるとクリップスタジオをおすすめしますが、トーン化せずにグレースケールのまま使用する場合にはphotoshopなどほかの画像編集ソフトでも代替可能です。

機械的にできる作業はAIを活用しつつ、アイディアを練ったり想像を膨らませたりする部分に避ける時間を増やしていきましょう!

コメント